新芽专题介绍:Sim2Real——域适应与域泛化

选择此专题并在新芽系列课程中获得优秀的同学,可以免去前期筛选考核流程,直接进入南开大学媒体计算团队以及国家人工智能学院等合作院校团队推免生招收面试的最后一轮。

一、专题介绍

1.1 研究背景与统一定义

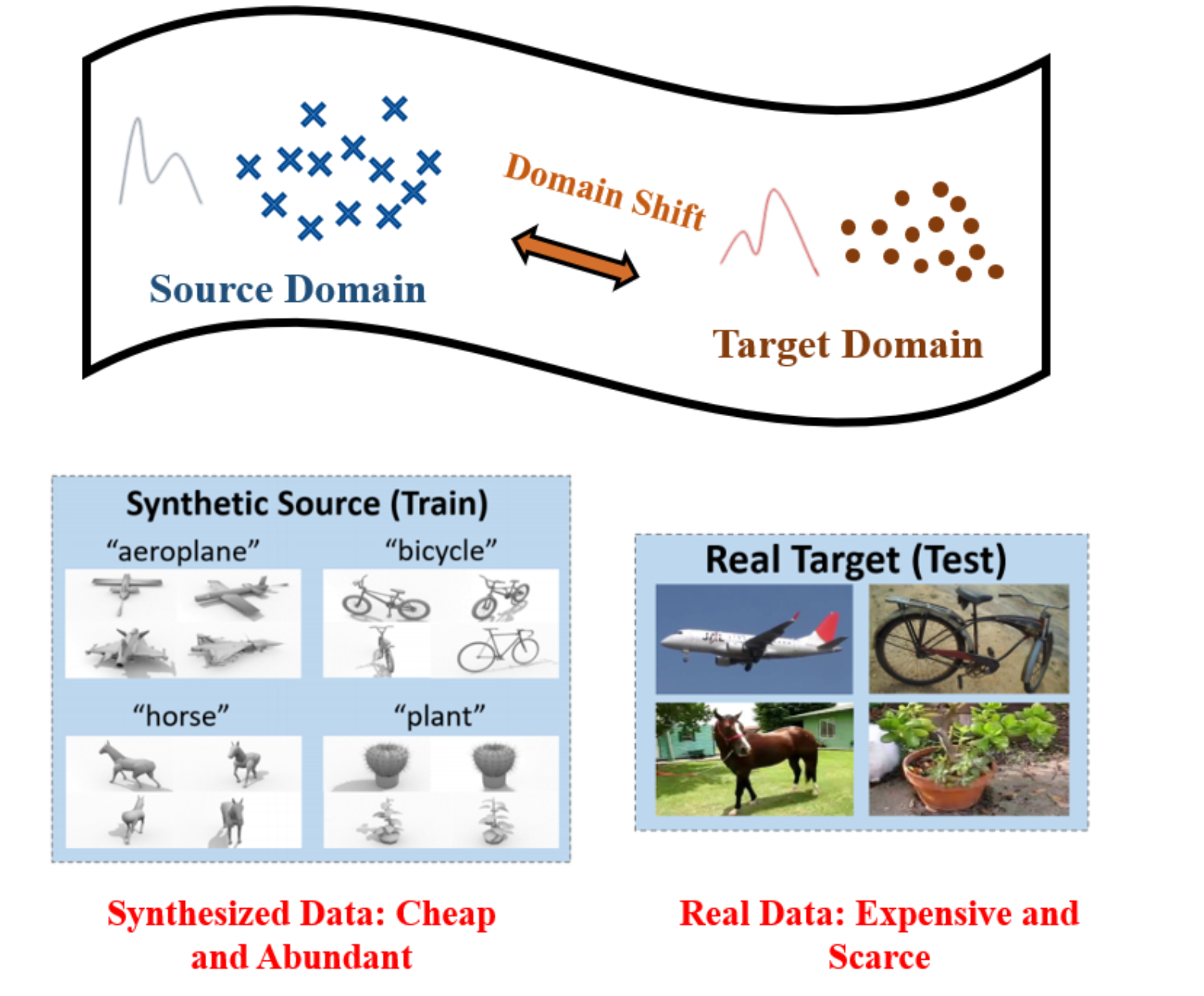

在计算机视觉中,Sim2Real指模型从模拟/合成域迁移到真实域时,由于数据分布不一致而产生的性能退化(域偏移,Domain Shift)。域偏移通常体现在以下维度:外观(光照、天气、纹理/噪声)、几何(视角、尺度、运动模糊)、传感器(成像响应、分辨率、白平衡/噪声模型)、上下文(背景共现、场景布局)以及标签空间(类别覆盖与分布)。

▲ 仿真域与真实域对比 典型跨域场景示例:

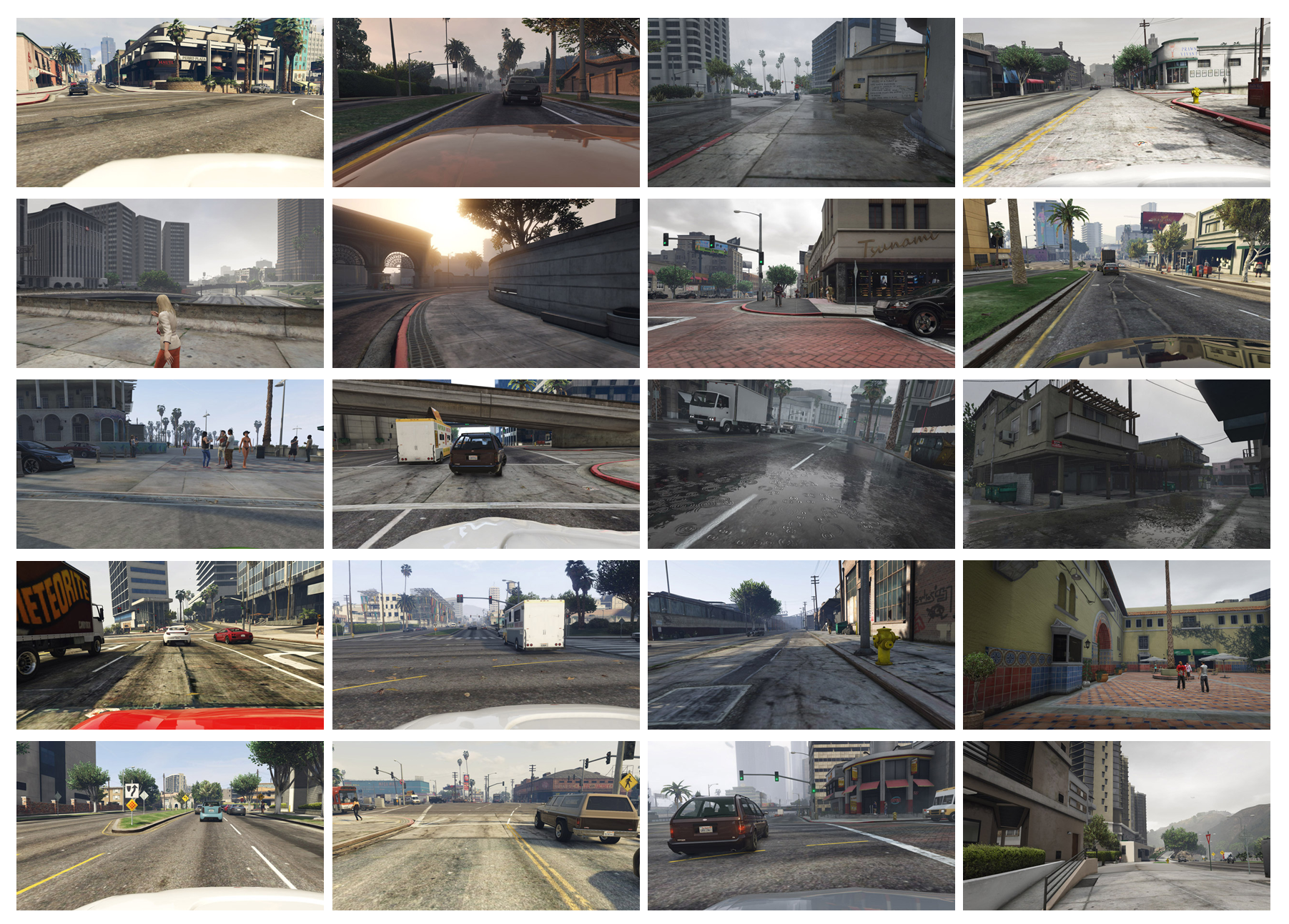

- 自动驾驶(合成→真实/晴天→夜雨雾):在 CARLA/GTA 等仿真数据上训练的检测器,迁移到真实城市道路或恶劣天气时精度显著下降(逆光、雨滴、反射、运动模糊)。

- 安防与无人机(可见光→红外/地面→空中):成像模态或视角变化导致外观与尺度分布改变,出现小目标、遮挡、背景干扰增强等问题。

- 工业质检(虚拟贴图→真实工件):仿真纹理规则、噪声可控,真实工件存在不规则划痕、油污与反光,使得特征分布产生系统偏移。

图2.游戏GTA5中采集的图像示例–Playing for Data: Ground Truth from Computer Game

围绕域偏移,形成两条基本范式:

- 域自适应(Domain Adaptation, DA):在已知目标域(或目标域簇)上进行适配。常见子设定包括

SDA/SSDA(目标域多/少量标注)、UDA(目标域无标注,最常见)、SFDA(适配期不再访问源数据,仅用源模型与目标未标注数据)、TTA/CTTA(测试时/持续测试时适配,应对在线域漂移)。 - 域泛化(Domain Generalization, DG):训练阶段不接触目标域,只利用一个或多个源域学习域不变表征,以便对未知新域直接泛化。

注:DA ≠ UDA。UDA 是 DA 的一种常用设定;DA 还包含 SSDA/SFDA/TTA 等更广场景。

为简明起见,这里仅给出 UDA 的典型目标(在源域监督训练,同时缩小源/目标特征分布差异):

其中

1.2 研究意义

(1)数据与标注成本可控。 真实环境的高质量标注昂贵且难以覆盖全部场景。DA 可在零/少标注条件下将模型迁移到新城市、新传感器或新时段;DG 则力求一次训练、多处可用,显著降低数据获取与人工标注成本。

(2)工程部署的可移植性与可维护性。 设备升级(相机换型)、地域迁移(跨国家/城市)、场景变化(白天→夜晚、晴天→恶劣天气)常导致模型失配。DA/TTA 支持快速适配与在线校准,DG 提升对版本/环境变化的天然稳健性,缩短从实验到上线的周期。

(3)鲁棒性与安全性提升。 在自动驾驶、安防与无人机等安全敏感场景,模型需要面对长尾与极端条件(逆光、雨雾雪、低照度、遮挡、小目标)。DA/DG 有助于弱化模型对背景纹理和成像风格的依赖,增强对目标本体特征的关注,从而提高稳健性与安全裕度。

(4)仿真资源的有效利用。 仿真平台能够系统生成可控、可重复的样本与稀有情形(如极端天气、罕见交通事件)。通过跨域适配/泛化,可将仿真中学习到的能力迁移到真实系统,提升对罕见风险的覆盖。

1.3 当前主要挑战

- 外观/传感器差异显著:颜色、纹理、噪声、分辨率、动态范围差异导致特征带强域特性,迁移失效。

- 语义/上下文分布偏移:姿态/视角、场景布局、背景共现关系与类别分布差异诱发“伪相关”。

- 跨模态与持续漂移:可见光↔红外、合成点云↔真实激光雷达,以及白天↔夜晚/晴↔雨等时间连续变化,超出静态两域难度。

- 检测任务特有难点:相较分类/分割,检测还受尺度、前景-背景不平衡、定位与置信度校准等因素影响。

二、学习资料与参考文献

2.1 基础教材与学习材料

- 李沐等:《动手学深度学习》D2L(含配套视频)

- PyTorch 官方教程(可配合中文文档)

- 【霹雳吧啦Wz的个人空间-哔哩哔哩】 https://b23.tv/q1YT0dL (代码逐行解释)

实践建议:以小实验驱动学习(Colab/Kaggle),遇到概念再回溯,效率更高。

2.2 入门文献(经典、便于打地基)

- DANN — Domain-Adversarial Training of Neural Networks(JMLR 2016):梯度反转 + 对抗对齐。 https://arxiv.org/abs/1505.07818

- Deep CORAL(ECCV 2016):对齐源/目标特征二阶统计。 https://arxiv.org/abs/1607.01719

- Domain Adaptive Faster R-CNN(CVPR 2018,检测开山):图像/实例级判别器对齐。 https://openaccess.thecvf.com/content_cvpr_2018/papers/Chen_Domain_Adaptive_Faster_CVPR_2018_paper.pdf>

- AdaptSegNet(CVPR 2018,分割):输出空间对抗对齐。 https://arxiv.org/abs/1802.10349

- Deeper, Broader and Artier DG(PACS)(ICCV 2017):DG 早期代表作与多风格基准。 https://openaccess.thecvf.com/content_ICCV_2017/papers/Li_Deeper_Broader_and_ICCV_2017_paper.pdf>

2.3 进阶文献(以目标检测为主)

A. 目标检测 · 领域自适应(DA / SFDA / TTA)

- SEEN‑DA(CVPR 2025):提出“语义熵”引导的域感知注意力,结合 VLM 语义提升跨域检测适应。 [Paper] https://openaccess.thecvf.com/content/CVPR2025/papers/Li_SEEN-DA_SEmantic_ENtropy_guided_Domain-aware_Attention_for_Domain_Adaptive_Object_CVPR_2025_paper.pdf

- CAT(CVPR 2024):利用类间动态缓解伪标签失衡,强化 DA‑OD 鲁棒性。 [Paper] https://openaccess.thecvf.com/content/CVPR2024/papers/Kennerley_CAT_Exploiting_Inter-Class_Dynamics_for_Domain_Adaptive_Object_Detection_CVPR_2024_paper.pdf

- Active DA with False‑Negative Prediction(CVPR 2024):主动挑选“易漏检”样本做微量标注,显著提升迁移上限。 [Paper]https://openaccess.thecvf.com/content/CVPR2024/papers/Nakamura_Active_Domain_Adaptation_with_False_Negative_Prediction_for_Object_Detection_CVPR_2024_paper.pdf>

- Cross‑Domain Few‑Shot OD(ECCV 2024):构建 CD‑FSOD 基准并改进开集检测器以应对跨域少样本。

[Paper] https://www.ecva.net/papers/eccv_2024/papers_ECCV/papers/07562.pdf · - [Code] https://github.com/lovelyqian/CDFSOD-benchmark

B. 目标检测 · 领域泛化(DG)

- Generalized Diffusion Detector(GDD)(CVPR 2025):利用扩散模型多步中间特征挖掘域不变表示,提升 DG‑OD。 [Paper] https://openaccess.thecvf.com/content/CVPR2025/papers/He_Generalized_Diffusion_Detector_Mining_Robust_Features_from_Diffusion_Models_for_CVPR_2025_paper.pdf> ·

- [Code] https://github.com/huamiao1012/GDD

- Object‑Aware DG for OD(OA‑DG)(AAAI 2024):单源 DG‑OD 的对象感知增强(OA‑Mix + OA‑Loss)。 [Paper] https://ojs.aaai.org/index.php/AAAI/article/view/28076 · [Code] https://github.com/WoojuLee24/OA-DG

- Towards Generalized UAV OD(频域解耦)(IJCV 2024):面向 UAV 小目标场景的 DG‑OD。

[Paper] https://link.springer.com/article/10.1007/s11263-024-02108-5 · [Code] https://github.com/wangkunyu241/UAV-Frequency - Watching it in Dark(ECCV 2024):面向低照度域的目标感知表示学习,联动外观/语义双向对齐,适配检测/分类等高层任务。

[Paper] https://link.springer.com/book/10.1007/978-3-031-73226-3

C. 语义分割 · UDA / 通用设定(补充)

- CoPT(ECCV 2024):引入域无关文本嵌入促进分割 UDA 的语义对齐。

[Paper] https://www.ecva.net/papers/eccv_2024/papers_ECCV/papers/07950.pdf · [Code] https://github.com/cfmata/CoPT - HRDA / DAFormer(ECCV 2022 / CVPR 2022,强基线,便于对比)

[HRDA] https://www.ecva.net/papers/eccv_2022/papers_ECCV/papers/136900370.pdf · - [DAFormer] https://arxiv.org/abs/2111.14887

D. 综述 / 指南(推荐)

- A Comprehensive Survey on Source‑Free Domain Adaptation(TPAMI 2024)

[Paper] https://arxiv.org/abs/2302.11803 - Advances in Multimodal Adaptation & Generalization(arXiv 2025):多模态 DA/DG & 基于大模型/基础模型的最新进展综述。 [Paper] https://arxiv.org/abs/2501.18592

E. 可选扩展(Workshop / 预印本)

- Fully Test‑time Adaptation for OD(CVPRW 2024)

https://openaccess.thecvf.com/content/CVPR2024W/MAT/html/Ruan_Fully_Test-time_Adaptation_for_Object_Detection_CVPRW_2024_paper.html - Source‑Free DA for YOLO OD(ECCV 2024 Workshop/LNCS)

https://link.springer.com/content/pdf/10.1007/978-3-031-91672-4_14 - SAGA(RGB→IR DA)(CVPRW 2025)

https://openaccess.thecvf.com/content/CVPR2025W/PBVS/papers/D_SAGA_Semantic-Aware_Gray_color_Augmentation_for_Visible-to-Thermal_Domain_Adaptation_across_CVPRW_2025_paper.pdf - Weakly Supervised Test‑Time DA for OD(arXiv 2024)

https://arxiv.org/abs/2407.05607 - Diffusion Domain Teacher(DA‑OD)(arXiv 2025)

https://arxiv.org/abs/2506.04211 - Attention‑based Class‑Conditioned Alignment for MSDA‑OD(WACV 2025)

https://openaccess.thecvf.com/content/WACV2025/html/Belal_Attention-Based_Class-Conditioned_Alignment_for_Multi-Source_Domain_Adaptation_of_Object_Detectors_WACV_2025_paper.html - OpenGDA(图域适应基准)(CIKM 2023/ArXiv)

https://arxiv.org/abs/2307.11341

2.4 目标检测方向精选清单(建议优先报告)

「检测为主」+「2024–2025 顶刊/顶会」+「覆盖 DA / DG / SFDA / TTA 代表作」

- DA/TTA:SEEN‑DA(CVPR 2025);CAT(CVPR 2024);Active DA with False‑Negative(CVPR 2024);CD‑FSOD(ECCV 2024)。

- DG:Generalized Diffusion Detector(CVPR 2025);OA‑DG(AAAI 2024);Generalized UAV OD(IJCV 2024);Watching it in Dark(ECCV 2024)。

- 综述:SFDA Survey(TPAMI 2024);多模态 DA/DG Survey(arXiv 2025)。

三、结语与期望

跨越“模拟→真实”的鸿沟,是视觉系统落地的关键一步。通过本专题,你将系统把握 DA/DG/SFDA/TTA 的问题设定、评测基准与代表方法,完成读论文 → 复现对比 → 小型改进的科研链条。期待你在最终汇报中:

1)清晰定义任务与设定;2)给出强基线与严格评测;3)提出小而有效的改进(如:更稳健的伪标签/对齐策略、利用 VLM/扩散模型的蒸馏/指导、频域/风格解耦、测试期稳定化等),推动模型更稳泛化、更易适配。